O Brasil está se tornando um “país conectado”, muito em parte graças ao acesso à internet móvel. Além de ser mais flexível do que as conexões residenciais, elas são cada vez mais baratas, disponíveis até em planos pré-pago. Por conta deste fácil acesso, o número de pessoas conectadas a redes sociais, serviços de mensagens instantâneas e e-mails em qualquer lugar tem aumentado em um bom ritmo. Mas… qual desses planos é o mais vantajoso para você usar no seu smartphone?

Nesse artigo que o TechTudo preparou para você, vamos fazer uma análise das atuais ofertas das quatro principais operadoras brasileiras, demonstrando como está o cenário da internet móvel pré-paga no Brasil. Vamos mostrar as principais características, e os prós e contras de cada plano. Você verá que existem serviços para todos os tipos de usuários e smartphones - mesmo pra quem tem um smartphone “top” e não quer gastar muito com um plano de dados.

Mas antes, vale lembrar que…

Para alguns perfis de uso, e principalmente em alguns smartphones, o uso da internet pré-paga é apenas um recurso de emergência. Entendemos que o propósito de nossa análise é orientar o consumidor que não pode (ou não quer) gastar muito dinheiro em um plano de dados, mas que deseja estar minimamente conectado para suas atividades online. Por outro lado, não adianta muita coisa você adquirir um smartphone como o iPhone, o Galaxy S II ou o Motorola RAZR se você não contratar um bom plano de dados. Apesar de alguns planos descritos a seguir permitirem um uso satisfatório com os smartphones “top” de linha, recomendamos que o usuário considere a possibilidade de adquirir um plano de dados pós-pago, onde o limite de dados e a velocidade ofertada são maiores.

Outro detalhe a ser considerado: os ajustes de consumo de dados nos smartphones (independentemente do tipo de aparelho) também é um fator relevante na hora de escolher seu plano. Telefones capazes de gerenciar com eficiência o consumo de dados, com opções que desabilitem a conexão quando o telefone ficar em stand-by, são altamente recomendados para quem contrata planos de internet pré-pagos. Além de controlar o volume de dados, oferecem uma melhor relação custo-benefício no final do mês.

Por fim, alguns aplicativos específicos, como o Opera Mini e o WhatsApp possuem um consumo menor de dados. Vale a pena o usuário dar preferência aos programas que comprovadamente consomem uma menor quantidade de dados. Assim você terá um bom equilíbrio na relação “preço pago/serviço oferecido”, já que você pode otimizar o desempenho de sua conexão - principalmente para o caso de você contratar um pacote com redução de velocidade depois de um período determinado de uso.

Dito isso, segue abaixo nossas observações sobre os planos ofertados pelas principais operadoras nacionais.

Vivo

Plano de internet Vivo Pré (Foto: Reprodução)

Plano de internet Vivo Pré (Foto: Reprodução)

Internet no Vivo Pré/Controle

Preço: R$ 9,90/mês

Tipo de conexão: 3G/GPRS/EDGE ilimitada (com redução de velocidade)

Pacote de dados: 20 MB

Velocidade: até 1 Mbps (no limite de 20 MB de dados; depois desse limite, a velocidade é reduzida para 32 Kbps)

O Vivo Pré surgiu como uma alternativa aos usuários do serviço Vivo ON, que desejavam uma maior liberdade de acesso à web, mas que ao mesmo tempo não querem pagar muito por um acesso simples a partir do seu celular ou smartphone. Com esse tipo de conexão o usuário não fica limitado apenas às redes sociais e e-mails, mas pode navegar por todo e qualquer tipo de conteúdo na internet, sem nenhum tipo de cobrança adicional.

O serviço é um dos mais baratos entre as operadoras, custando R$ 0,33 por dia de acesso. Porém, diferentemente de outras operadoras, o Vivo Internet Pré Ilimitado obriga o usuário a assinar o pacote de acesso pelo mês todo, sem contar com uma opção de cobrança avulsa pelo dia acessado (algo mais vantajoso para boa parte dos usuários).

Uma das vantagens do serviço é que ele oferece a velocidade mais alta entre os planos pré-pagos (1 Mbps). Porém, a alegria dura muito pouco: o serviço só garante essa velocidade até o consumo de 20 MB de dados. Ultrapassado esse limite, você vai ter que se contentar com uma velocidade de 32 Kbps até o final do período de 30 dias contratados. No início de um novo ciclo, o valor correspondente ao plano é debitado dos créditos do usuário, e a velocidade máxima é restabelecida.

Recomendado para: os usuários que só vão acessar e-mails e redes sociais ocasionalmente, em telefones com baixo consumo de dados. Para quem utiliza as redes sociais de forma mais intensa e deixa o serviço de pushmail do iPhone ligado, esse pacote de dados só vai funcionar de forma plena por poucos dias. Depois disso, com a queda de velocidade, o serviço se torna inviável para os mais exigentes. Veja mais informações.

Oi

Plano de internet pré da Oi (Foto: Reprodução)

Plano de internet pré da Oi (Foto: Reprodução)

Oi Dados (para Oi Celular e Oi Controle)

Preço: R$ 9,90/mês, R$ 2,90/semana, R$ 0,50/dia

Tipo de conexão: 3G/GPRS EDGE ilimitada (com redução de velocidade)

Pacote de dados: 30 MB (mensal), 15 MB (semanal), 5 MB (diário)

Velocidade: até 1 Mbps (no limite de dados previamente estabelecido; depois desse limite a velocidade é reduzida para 50 Kbps)

É uma variante da proposta oferecida pela Vivo, mas com maior flexibilidade de preços e opções. Aqui o usuário pode escolher qual o período de acesso que deseja, com o valor que melhor cabe no bolso, dependendo do seu propósito de uso. Além disso, a oferta de internet pré-paga da Oi pode ser integrada a outros pacotes de serviços, trazendo uma combinação de produtos e funcionalidades da operadora.

A opção de conexão mensal possui um pacote de dados um pouco maior do que aquele ofertado pela Vivo, mas não muito: apenas 30 MB. Ao ultrapassar esse consumo, o usuário ficará limitado a uma conexão com velocidade de 50 Kbps até o final do período. A regra de redução de velocidade vale também para os pacotes semanal e mensal.

A vantagem da Oi é permitir que o usuário faça a contratação avulsa do serviço, de acordo com a sua necessidade. Para aqueles que não precisam de uma internet móvel, recomendamos a prática da contratação diária. A relação preço/pacote de dados é melhor (R$ 3,50/35 MB por semana, contra R$ 2,90/15 MB por semana), e oferece um uso mais completo do celular ou smartphone. Mesmo assim, o pacote diário oferece apenas a metade do volume de dados de alguns concorrentes.

Recomendado para: os usuários que não vão utilizar a internet móvel todos os dias. Para aqueles que só precisam acessar a web em dias e situações específicas, e para proprietários de smartphones que possuem um uso moderado de dados (e-mails, mensagens instantâneas e redes sociais). Veja mais informações.

Tim

Oferta de internet pré da Tim (Foto: Reprodução)

Oferta de internet pré da Tim (Foto: Reprodução)

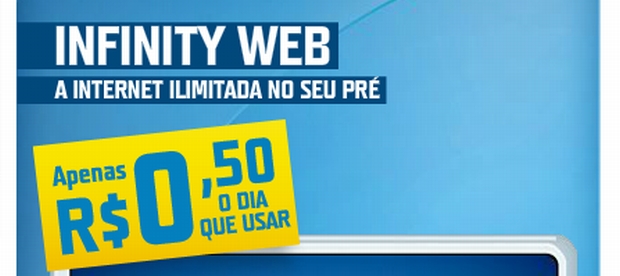

Tim Infinity Web Pré

Preço: R$ 0,50/dia

Tipo de conexão: 3G/GPRS/EDGE ilimitada (com redução de velocidade)

Pacote de dados: 10 MB/dia (ou 300 MB/mês)

Velocidade: até 300 Kbps (no limite de dados previamente estabelecido; depois desse limite, a velocidade é reduzida para 50 Kbps)

A Tim foi pioneira na proposta de internet pré-paga ilimitada no Brasil. Lançou o serviço em 2010, e hoje se tornou um dos pilares de serviços oferecidos pela operadora, que também integra serviços de torpedos e chamadas ilimitadas aos seus serviços (de Tim para Tim).

Diferentemente dos serviços da Vivo e da Oi, não é necessário se cadastrar previamente para a usar a conexão, pois o serviço está automaticamente inserido na linha do usuário. Ou seja: assim que você compra o chip, basta colocá-lo no seu celular e usar a internet. Esse benefício torna o produto mais fácil de usar, ótimo para o público-alvo que a operadora deseja conquistar.

Por outro lado, a conexão é consideravelmente mais lenta do que os seus concorrentes. Você estará limitado aos 300 Kbps ofertados pela operadora, e dentro de um limite de até 300 MB de dados ao mês. Fazendo as contas para um consumo mensal (o que não deve acontecer, uma vez que o serviço só debita créditos do usuário no dia que utilizar a conexão) o valor máximo de R$ 15,50/mês (para os meses de 31 dias) por até 300 MB de dados é a melhor relação custo/benefício que os usuários podem encontrar.

A quantidade de 10 MB de dados diários é aceitável, até mesmo para que usuários de iPhone e Androids “top” aproveitem um pouco mais dos seus dispositivos. É claro que não dá pra ver vídeos de forma desenfreada, mas é possível ver seus e-mails, atualizar as redes sociais e trocar mensagens instantâneas durante um dia de trabalho, e com uma certa folga.

Recomendado para: os usuários que não vão utilizar a conexão móvel todos os dias. Para quem tem um uso mais elaborado dessa conexão, recebendo um volume maior de e-mails e mensagens instantâneas. Para quem tem um smartphone com recursos avançados, mas não pode contratar um plano de dados pós. Veja mais informações.

Claro

Oferta de internet pré da Claro (Foto: Reprodução)

Oferta de internet pré da Claro (Foto: Reprodução)

Internet Pré a R$ 0,50/dia ou Pacotes Internet Pré

Preço: R$ 0,50/dia, R$ 6,90/quinzenal, R$ 11,90/mês

Tipo de conexão: 3G/GPRS/EDGE ilimitada (com redução de velocidade)

Pacote de dados: 10 MB/dia, 150 MB/quinzena, 300 MB/mês

Velocidade: até 300 Kbps (no limite de dados previamente estabelecido; depois desse limite, a velocidade é reduzida para 32 Kbps)

A Claro ataca em duas frentes. Quando lançou a sua opção de internet pré-paga, ofereceu dois pacotes avulsos: um com período de 15 dias, com quantidade de dados de até 150 MB; e outro para 30 dias, com dados de até 300 MB. Os valores são fixos por período, e a contratação é feita pelo site ou por SMS. Porém, quando a Claro percebeu que a oferta da Tim de cobrança avulsa por dia era mais vantajosa para o seu público-alvo, ela resolveu repetir a mesma estratégia.

Com isso, a Claro possui ofertas flexíveis para diferentes perfis de uso. Os pacotes quinzenal e mensal possuem uma peculiaridade que pode ser interessante para muitos usuários: diferentemente dos concorrentes, o pacote de 150 MB ou 300 MB de dados não são fracionados em 10 MB por dia. Se o usuário precisar utilizar um volume de dados maior em um determinado dia, não terá a tal queda de velocidade naquele dia em específico, mas só quando atingir a cota total do pacote. Esse detalhe é muito importante para quem sabe que vai usar um grande volume de dados em situações especiais. Além disso, nesse cenário, a utilização moderada desse pacote com os smartphones mais avançados é viável, apesar da velocidade de 300 Kbps.

Já na oferta de R$ 0,50 por dia de acesso, as mesmas características descritas no plano da Tim valem para o serviço da Claro, com a diferença de que, nesse caso, a redução da velocidade ao atingir a cota de 10 MB/dia é mais drástica, limitando a velocidade para 32 Kbps. Na prática, para troca de mensagens e emails, a velocidade mais baixa não traz diferenças tão grandes, e por isso pode ser desonsiderado se você aguentar ficar sem ver vídeos do YouTube longe de casa.

Recomendado para: os usuários que vão utilizar a internet no celular de forma ocasional. Para quem vai utilizar um volume de dados acima dos 10 MB em situações específicas. Para usuários de smartphones avançados, que podem ter um uso moderado com o pacote de dados, e se contentam com uma velocidade reduzida para o acesso à web. Veja mais informações.

Fonte: Eduardo Moreira para o TechTudo

Plano de internet Vivo Pré (Foto: Reprodução)

Plano de internet Vivo Pré (Foto: Reprodução) Plano de internet pré da Oi (Foto: Reprodução)

Plano de internet pré da Oi (Foto: Reprodução) Oferta de internet pré da Tim (Foto: Reprodução)

Oferta de internet pré da Tim (Foto: Reprodução) Oferta de internet pré da Claro (Foto: Reprodução)

Oferta de internet pré da Claro (Foto: Reprodução)