Nos dias de hoje, as pessoas, empresas e instituições estão sempre ligadas e conectadas. O mundo da comunicação instantânea e da conectividade constante que consideramos garantido é limitado apenas pela nossa capacidade de criar e inovar – e isso parece não ter fim. A realidade, porém, é que esse mesmo mundo de conectividade também cria riscos.

O risco é determinado por três fatores: oportunidade, motivação e capacidade. Quem conseguir afetar qualquer um ou mais de um desses fatores reduzirá o risco geral. No atual ambiente da conectividade, os três fatores – oportunidade, motivação e capacidade – crescem desordenadamente.

A começar pelo fator motivação, ouve-se muito sobre vários criminosos que são altamente motivados, por dinheiro, pelo orgulho nacional, pela religião ou por algum outro fator atraente. Esses criminosos têm muito a ganhar e quase nada a perder, pois as leis, penalidades e certa incapacidade de impô-las tornam os cibercrimes extremamente atraentes e rentáveis.

Acrescente-se a isso o fato de que o nível de qualificação da maioria dos cibercriminosos tem aumentado radicalmente desde a época em que os adolescentes “trabalhavam” nas garagens de suas casas. Agora, o perfil que encontramos é o de profissionais sérios e até mesmo de empresas que são “contratadas” para realizarem ataques digitais. Simplificando, é relativamente fácil executar ataques, utilizando milhares e até milhões de computadores para atacar um único alvo, criando exércitos virtuais que são muito menos dispendiosos e mais dinâmicos do que os exércitos físicos. As ferramentas e técnicas estão bem documentadas, são fáceis de encontrar e estão ao alcance de pessoas mal-intencionadas armadas com um laptop e uma conexão à Internet.

Mas quem tem a oportunidade? Nesse outro fator de risco, certamente é quem está dentro das organizações – pessoas que conhecem as empresas, bem como seus dados e sistemas mais sigilosos – diante de uma oportunidade ideal. Mas, em um mundo altamente interconectado, um atacante (hacker, cracker ou pessoa mal-intencionada) não precisa necessariamente estar dentro de uma organização para entrar nela.

Na verdade, praticamente qualquer dispositivo que usamos normalmente – celulares, tablets, notebooks, pen drives e até mesmo um equipamento médico – é perfeitamente capaz de levar um atacante para dentro da empresa. Qualquer coisa na qual alguém possa se conectar ou à qual possa ser conectado – através de USB, conexão de rede com fio, conexão de rede Wi-Fi, Bluetooth, RFID – é suficiente para permitir a entrada de um cibercriminoso.

No entanto, a outra importante realidade neste mundo conectado é a forma como os dispositivos conectados estão ajudando as pessoas a solucionarem problemas consideráveis, e muitos desses problemas são altamente pessoais. Por exemplo, os pacientes com doenças cardíacas podem ficar em casa, enquanto os médicos monitoram suas condições em suas clínicas, os alunos nas zonas rurais podem ter aulas em grandes universidades via on-line, os motoristas podem travar a distância as portas dos seus carros ou serem encaminhados ao seu exato destino.

As empresas inovadoras têm todos os incentivos para oferecerem cada vez mais produtos e serviços para atender às necessidades mais fundamentais dos consumidores e, ao mesmo tempo, torná-los mais interconectados. Essa é uma fortíssima tendência de mercado que continuará no futuro. Mas, a menos que os dispositivos sejam bloqueados e protegidos desde o seu projeto, os cibercriminosos terão ainda mais oportunidades de lucro.

O risco para cidadãos e consumidores

A maioria dos consumidores espera, quando acessa a Internet, que suas informações estejam em sigilo e que seus filhos estejam navegando de forma segura, desde que não acessem sites proibidos por eles. No entanto, isso é uma ilusão, pois para cada atividade on-line há uma forma de ataque e uma maneira adequada para prevenir ameaças.

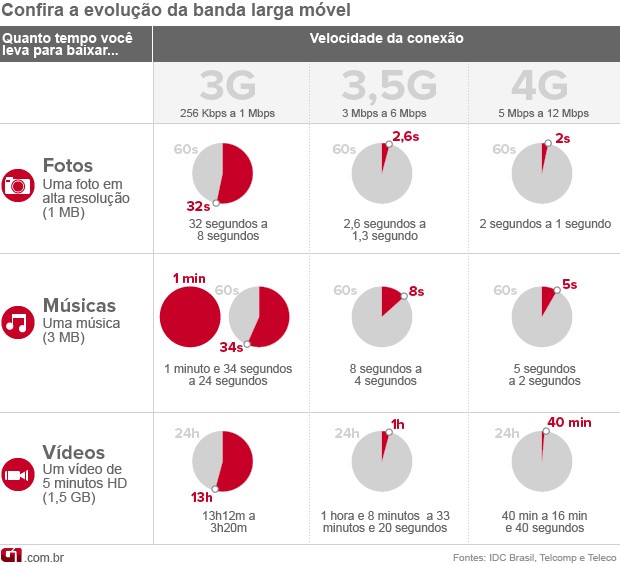

As ameaças que os consumidores enfrentam cobrem toda a gama de possibilidades de ataques, envolvendo desde o roubo de identidade até a perda de informações pessoais ou financeiras, a infecção dos sistemas e computadores e a destruição de hardware, software e dados. O advento das novas tecnologias móveis, especialmente dos smartphones e tablets, abriu novos vetores de ataque para os hackers ou atacantes.

Segundo recente testemunho dado pelo Dr. Rangam Subramanian, do Idaho National Labs, ao Comitê de Ciência da Câmara dos Estados Unidos, todos os setores essenciais da economia dependerão, em breve, das conexões sem fio: Energia, Segurança Pública, Finanças, Saúde, Transporte, Entretenimento e muito mais. No entanto, a cada facilidade, recurso e inovação que a tecnologia sem fio proporciona, haverá a introdução de mais oportunidades para os hackers atacarem.

Atualmente, pessoas em todo o mundo realizam atividades de Internet banking, fazem compras on-line, entre outros serviços, através do acesso sem fio em pontos de acesso, usando seus smartphones, o que pode levá-las diretamente às armadilhas montadas pelos cibercriminosos. E a revolução das conexões sem fio está apenas no início.

O risco à propriedade intelectual

Um dos tipos mais insidiosos de ameaças para os indivíduos, as empresas, as organizações, os órgãos públicos e a economia em geral é o roubo de propriedade intelectual. Hoje, os desenvolvedores de malware combinam vulnerabilidades da Web, de hospedagem e de rede com spam, rootkits (ameaça invisível que se esconde dentro de um software autorizado no sistema operacional de um computador), spyware (programas espiões), worms (programa de computador que pode se reproduzir e enviar cópias de si mesmo para outros computadores em uma rede) e outros meios de ataque. O malware também pode ser distribuído indiretamente por redes de computadores que foram corrompidas por um cibercriminoso – conhecidas como “botnets” ou rede de robôs – que reúnem uma série de computadores infectados conectados à Internet.

Outro tipo de ataque que tem se expandido rapidamente é conhecido como ameaça avançada persistente (APT). A APT é, essencialmente, um intruso desleal e persistente cuja intenção é “voar abaixo do radar” e explorar e roubar silenciosamente o conteúdo da rede atacada.

Esses ataques são significativos porque são gerenciados por equipes bem coordenadas e organizadas que conseguem retirar bilhões de dólares em propriedade intelectual de empresas líderes mundiais dos setores de Tecnologia da Informação, Defesa e Energia – setores estratégicos e essenciais para o crescimento econômico e que estão sob a segurança nacional de qualquer país.

Esses ataques discretos são, muitas vezes, mais perigosos que as incursões explícitas, porque são um tipo de espionagem virtual que dá acesso silencioso e constante a informações institucionais protegidas. E o alcance dessas APTs não é limitado, pois elas podem afetar qualquer empresa, órgão do governo ou nação, independentemente do setor, da região geográfica ou do porte.

Um levantamento realizado em 2010 revelou que 60% das organizações relataram uma “perda crônica e recorrente” de informações confidenciais. O custo médio de uma violação de dados atingiu US$ 7,2 milhões em 2010 e custou às empresas US$ 214 por registro de dados comprometido, de acordo com o Instituto Ponemon, nos Estados Unidos. Esse é apenas o custo da reação interna a uma violação de dados.

Se a propriedade intelectual de uma empresa for roubada, esse roubo pode dizimar uma organização.

O risco para os sistemas e as infraestruturas críticas

Como os políticos e governos de diferentes localidades começaram a reconhecer, um ciberataque ou uma série de ciberataques às infraestruturas críticas do país poderia ser algo devastador para o nosso modo de vida. Vejamos a rede de energia elétrica, a qual é de longe a mais vulnerável das infraestruturas críticas.

Quase todos os aspectos da população mundial dependem da energia elétrica – desde a produção de bens até o salvamento de vidas, da defesa do país à realização de operações bancárias e comerciais por meio eletrônico, de simples comunicações à alimentação das nossas famílias de maneira segura. No entanto, os sistemas utilizados para gerenciar nossa eletricidade (sistemas SCADA – Supervisory Control and Data Acquisition ou Controle de Supervisão e Aquisição de Dados) são obsoletos, funcionam em sistemas operacionais disponíveis no mercado e seu projeto mudou pouco desde sua introdução no mercado, décadas atrás.

Esses sistemas nunca foram projetados nem construídos de forma segura e certamente não foram feitos para se conectarem à Internet. Atualmente, descobrimos que muitas empresas de energia elétrica ainda usam senhas predefinidas fornecidas pelos fornecedores porque facilitam o acesso em momentos de crise ou para manutenção e reparos.

O que acontece quando ocorrem várias falhas ou manipulações de sistema simultaneamente na rede elétrica? Os especialistas do setor reconhecem que a rede não está equipada, atualmente, para lidar com essa situação. Embora os especialistas afirmem que as chances de um acontecimento natural ou um ataque físico que leve a essa situação sejam bastante reduzidas, eles não estão preparados para dizer o mesmo em relação aos ciberataques – a ameaça que, hoje, é a mais capacitada para dar origem a esse tipo de falha de energia elétrica.

Embora muitos desses setores essenciais (Finanças, Minas e Energia, Varejo, entre outros) tenham sistemas de emergência que lhes permitam manter as operações durante uma falta de energia, esses sistemas de emergência são projetados para operarem temporariamente, não a longo prazo.

Segurança no projeto

Acrescentar recursos de segurança a sistemas depois que eles foram desenvolvidos é uma batalha perdida. Lembram-se do teto solar em veículos, na década de 80? A única maneira de conseguir um teto solar era instalá-lo depois da compra do carro. Os fabricantes não ofereciam esse acessório nos veículos novos. Assim, muitos tetos solares apresentavam vazamentos. Atualmente, todo fabricante oferece teto solar como opcional nos carros novos e não houve mais vazamentos!

Com a segurança da informação acontece o mesmo: a proteção deve vir incorporada nos equipamentos, nos sistemas e nas redes desde o início do processo de desenvolvimento. A segurança deve ser intrínseca aos processos de pensamento de uma organização, aos seus processos de negócios e também aos de criação, desenvolvimento e fabricação. Ou seja, deve ser incorporada a um elemento de produto ou de rede de modo a se tornar parte integrante do funcionamento do produto ou do elemento. Essa abordagem não só é mais eficaz como também é menos incômoda e mais econômica do que tentar proteger sistemas cuja segurança é intrinsecamente baixa.

Recomendações – setor público

Dado o nível de ameaça à segurança da informação, os governos têm um interesse legítimo em assegurar que seus países estejam protegidos contra ciberataques. A primeira ordem deve ser que o governo proteja completamente suas próprias instituições. Os governos também têm a obrigação de trabalhar com empresas e cidadãos para elevar o nível de segurança no trabalho e nas residências. Adotar incentivos positivos, em vez de negativos – como as exigências e normas do Poder Público – é a maneira mais eficaz de promover níveis mais elevados de confiança e cooperação real entre o setor privado e o governo, de modo que as empresas privadas comprometam-se plenamente – clientes e fornecedores de produtos e serviços de TI – com os princípios e a implementação da segurança no projeto, para ajudar a tornar seus países mais seguros no futuro.

Conclusão

O desafio da segurança da informação enfrentado pelos países é um assunto sério que exige uma evolução na maneira como os setores público e privado colaboram entre si. Cada setor tem seu próprio conjunto de recursos básicos. Apenas o governo pode implementar o complexo conjunto de reações organizacionais e políticas necessárias para combater a crescente ameaça à segurança da informação. As principais empresas de tecnologia da informação e seus clientes estão em posição ideal para agir como sistemas de alerta prévio, capazes de identificar e ajudar a enfrentar os ataques à segurança da informação.

Especialmente as empresas de tecnologia da informação voltadas à segurança têm os recursos e os incentivos econômicos para continuar inventando, inovando e desenvolvendo as tecnologias e soluções necessárias para colocar-nos à frente dos sofisticados atacantes virtuais.

Os setores público e privado mundiais têm feito progressos importantes para enfrentar o desafio da segurança. Ao trabalharem juntos para que os modelos de colaboração evoluam cada vez mais, será possível alcançar êxito na proteção dos países contra a ameaça dos ciberataques.

Stuart McClure, diretor mundial de tecnologia (CTO – Chief Technology Officer) da McAfee